Was ist ein Crawler?

Geschrieben von Leo Kobes

Webcrawler sind Programme, die das Internet durchforsten, um Webseiten zu analysieren, zu indexieren und Informationen zu sammeln. Sie sind das Herzstück von Suchmaschinen wie Google, können aber auch für fragwürdige Zwecke eingesetzt werden. In diesem Beitrag erfährst du, wie Webcrawler funktionieren, wofür sie genutzt werden und wie du dich vor unerwünschtem Crawling schützen kannst.

1. Was ist ein Webcrawler?

Ein Webcrawler (auch Spider, Bot oder Searchbot genannt) ist ein Programm, das sich automatisch durch das Internet bewegt, indem es von einer Webseite zur nächsten springt. Das Wort „to crawl“ bedeutet im Englischen „kriechen“ – und genau das tut ein Crawler: Er „kriecht“ von Link zu Link und sammelt dabei Informationen.

Als HTTP-Client funktioniert er nach einem einfachen Prinzip:

- Er sendet eine Anfrage (Request) an eine Webseite.

- Der Webserver liefert die Antwort (Response) zurück, meist als HTML-Seite.

- Der Crawler analysiert den Inhalt und folgt den enthaltenen Links.

Diese gesammelten Daten können dann für verschiedene Zwecke genutzt werden – beispielsweise für Suchmaschinen, die so das Web indexieren und Websites in ihren Suchergebnissen anzeigen.

2. Wie funktioniert Web Crawling?

Das Crawling folgt einem klaren Prozess:

- Start-URLs: Der Crawler beginnt mit einer vordefinierten Liste an Webseiten.

- Speicherung und Analyse: Er lädt die Seiten herunter und überprüft sie auf weitere Links.

- Link-Verfolgung: Gefundene Links werden gespeichert und weiterverfolgt.

- Begrenzung des Crawling-Prozesses: Das Crawling endet, wenn entweder keine neuen Links mehr gefunden werden oder eine vorher festgelegte Grenze erreicht ist.

Da das Internet riesig ist, durchsuchen Crawler niemals das gesamte Web. Stattdessen setzen sie Filter ein, um nur relevante Inhalte zu analysieren.

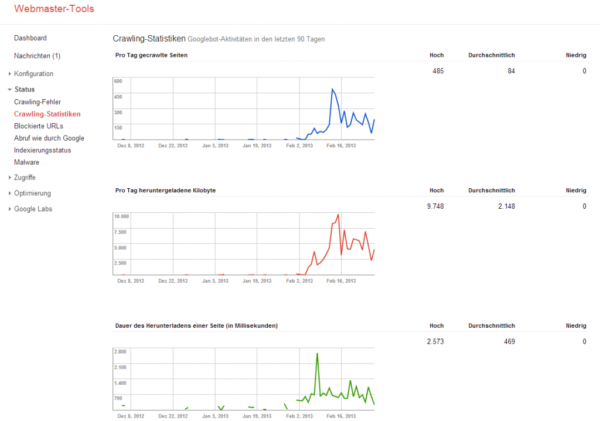

Beispiel: Googlebot – Der Crawler von Google

Der Googlebot ist der Webcrawler von Google. Er analysiert regelmäßig Webseiten, um die Suchergebnisse aktuell zu halten. Dabei entscheidet er anhand von Faktoren wie Ladegeschwindigkeit, Relevanz und Struktur, welche Seiten priorisiert werden.

Beispiel vom Google Crawler

3. Wofür werden Crawler genutzt?

Webcrawler haben viele Einsatzgebiete – nicht nur für Suchmaschinen.

3.1 Suchmaschinenindexierung

Suchmaschinen wie Google, Bing oder Yahoo nutzen Crawler, um Webseiten zu entdecken und zu indexieren. Nur so können sie aktuelle und relevante Ergebnisse liefern.

3.2 Datenanalyse und Marktforschung

Viele Unternehmen setzen Crawler ein, um Informationen aus dem Web zu sammeln – zum Beispiel für Preisvergleiche bei Online Shops, Produktbewertungen oder Marktanalysen.

3.3 Spezialisierte Crawler

- Focused Crawler: Konzentrieren sich auf ein bestimmtes Thema.

- Topical Crawler: Durchsuchen gezielt Webseiten zu bestimmten Branchen.

- Anti-Piraterie-Crawler: Suchen nach Urheberrechtsverletzungen.

Crawl dates in the Google cache

4. Freundliche Crawler vs. Schädliche Bots

Nicht alle Crawler sind harmlos. Während viele Bots nützliche Funktionen haben, gibt es auch schädliche Programme, die Daten für fragwürdige Zwecke sammeln.

4.1 Freundliche Crawler

✔ Suchmaschinen-Bots (z. B. Googlebot, Bingbot) – Indexieren Webseiten für Suchmaschinen.

✔ Archivierungs-Bots (z. B. Archive.org) – Speichern Webseiten langfristig.

✔ SEO-Crawler (z. B. Screaming Frog) – Helfen bei der Website-Optimierung.

4.2 Schädliche Bots

❌ Spam-Crawler – Sammeln E-Mail-Adressen für Spam.

❌ Preis-Scraper – Kopieren Inhalte von E-Commerce-Websites.

❌ Hacker-Bots – Suchen nach Sicherheitslücken.

5. Wie kannst du dich vor unerwünschtem Crawling schützen?

Zum Schutz deiner Webseite gibt es verschiedene Methoden.

5.1 Robots.txt – Steuert das Crawling

Mit einer robots.txt-Datei kannst du festlegen, welche Bereiche deiner Website von Crawlern durchsucht werden dürfen.

Beispiel für eine robots.txt-Datei:

5.2 .htaccess – Schädliche Bots blockieren

Mit einer .htaccess-Datei kannst du unerwünschte Bots von deiner Website aussperren.

Beispiel für das Blockieren eines bestimmten Bots:

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} BadBot [NC]

RewriteRule .* – [F,L]

Das blockiert alle Anfragen von einem Bot namens „BadBot“.

5.3 Weitere Schutzmaßnahmen

✔ CAPTCHAs – Verhindern automatisierte Anfragen.

✔ Rate Limiting – Begrenzen die Anzahl der Anfragen pro IP-Adresse.

✔ Bot-Detection-Software – Erkennen verdächtige Aktivitäten und blockieren sie.

6. Fazit: Webcrawler – Nützlich oder gefährlich?

Webcrawler sind ein essenzieller Bestandteil des Internets. Sie helfen Suchmaschinen, Inhalte zu indexieren, und liefern Unternehmen wertvolle Daten. Doch nicht alle Crawler sind harmlos – einige sammeln Daten für Spam oder Betrug.

Als Website-Betreiber solltest du deshalb darauf achten, freundliche Bots zuzulassen und schädliche zu blockieren. Mit robots.txt, .htaccess und weiteren Sicherheitsmaßnahmen kannst du selbst steuern, wer auf deine Inhalte zugreifen darf.

➡ Hast du schon Erfahrungen mit Webcrawlern gemacht? Teile deine Meinung in den Kommentaren! 🚀