Was ist ein Crawler?

Geschrieben von Leo Kobes

Als Crawler bezeichnet man Programme zum Auffinden und Indexieren von Webseiten. Alternative Bezeichnungen sind Webcrawler, Robots, Spider oder auch Searchbot. Das englische Verb „to crawl“ wird in diesem Zusammenhang meist mit „kriechen“ übersetzt. Denn der Webcrawler kriecht im Web sozusagen von einer URL zur nächsten. Als HTTP-Client sendet er eine URL (Request) an einen Server, der ihm daraufhin die angefragte Information bzw. Datei zusendet (Response).

Wie funktioniert Crawling?

Die Suche (search) beginnt mit der Hinzufügung von Start-URLs. Diese werden einzeln und auf dem Umweg über die Frontier dem Downloader übergeben, der – vereinfacht dargestellt – die betreffenden Webseiten kopiert und auf Verweise – also weitere URLs hin untersucht. Diese werden dann zur Grundlage des folgenden Suchkreisläufe. Je nach Voreinstellung kann die Suche andauern, bis keine neuen Verweise mehr gefunden werden oder bis ein definiertes Ziel erreicht wurde.

Aufgrund der hohen Zahl existierender Webseiten ist es faktisch nicht umsetzbar, dass ein Crawler tatsächlich alle Seiten durchsucht. Daher werden vorab Beschränkungen festgelegt, die sich auf URL-Adressen, Inhalte, Downloadzeiten oder auch bestimmte Elemente einer Webseite beziehen.

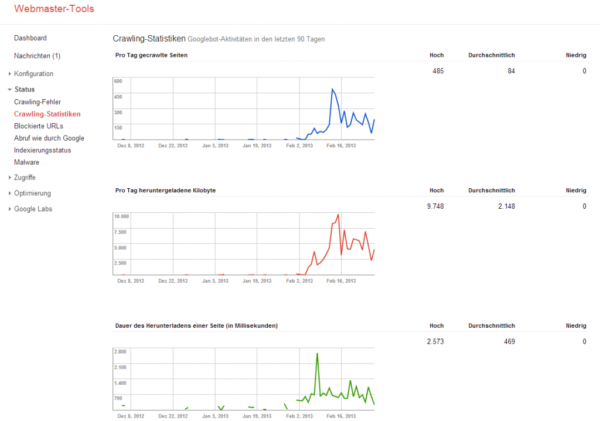

Beispiel vom Google Crawler

Wofür werden Crawler benötigt?

Wofür werden Crawler benötigt?

Genutzt werden Crawler hauptsächlich von Suchmaschinen zur Indexierung von Seiten, zur Listung verfügbarer URLs und zur Auswertung von Inhalten. Welche Aufgaben ein Bot im Einzelnen übernimmt und in welcher Abfolge er diese durchführt, hängt von der Programmierung ab.

Einige Programme indexieren zunächst und speichern Inhalte für eine spätere Sichtung ab. Andere erledigen diese Aufgaben parallel. Auch werden „focused“ oder „topical crawler“ eingesetzt, um Webseiten zu erfassen, die relevant für eine spezielle Thematik sind; manche Programme werden verwendet, um gezielt nach Urheberrechtsverletzungen zu suchen.

Crawl dates in the Google cache

Wie unterscheiden sich freundliche Crawler von schädlichen Bots?

Wer eine Website betreibt, möchte in der Regel auch gefunden werden und wird daher einer Indexierung zustimmen.

Ein großes Ärgernis stellen jedoch Programme dar, die elektronische Daten sammeln, um diese missbräuchlich zu verwenden. Ein solcher schädigender Use besteht beispielsweise im Sammeln von E-Mail-Adressen, die anschließend mit Spam überhäuft werden.

Als Schutzmaßnahme vor einer ungewünschten Indexierung soll der bereits 1994 entwickelte Robots Exclusion Standards dienen. Dieser legt fest, dass ein Crawler seine Sichtung mit dem Lesen der Datei robots.txt beginnt, in welcher der Betreiber einer Website definiert, welche Seiten indexiert werden dürfen.

Auch kann der Zugriff auf bestimmte Seiten ganz verweigert werden. Da sich die „bösen“ Bots im Gegensatz zu Suchmaschinenbetreibern wie Google aber nicht an derlei Regeln halten, müssen zum Schutz bestimmter Dateien und Seiten andere Maßnahmen ergriffen werden – wie beispielsweise das Anlegen von .htaccess-Dateien.

Stefan 1. Juli 2019 um 19:29

Wer nach einem Web-Crawler sucht um eine detaillierte SEO-Fehleranyse seiner Seite zu erhalten, dem kann ich nur JetOctopus empfehlen. Ich hab das Tool für unser Unternehmen erworben und nach einmaligen crawlen konnten 2.000 Seiten gefunden werden, die dringende SEO-Verbesserung nötig hatten, und 5.000 weitere Seite die noch minimal optimiert werden mussten. Nach der Fehlerbehebung hat sich der Traffic stark erhöht und unsere Seite wurde auch unter anderen Keywords auffindbar.

Den Einsatz von Web-Crawler kann ich jedem Unternehmen oder Seitenbetreiber nur empfehlen, vor allem bei größeren Seiten leistet JetOctopus wahre Wunder.